Llama 3 je Metin najnoviji veliki jezični model. Možete ga koristiti u razne svrhe, kao što je rješavanje vaših upita, dobivanje pomoći oko školske zadaće i projekata, itd. Lokalna implementacija Llame 3 na vaš Windows 11 stroj pomoći će vam da ga koristite bilo kada, čak i bez pristupa internetu. Ovaj vam članak pokazuje kako instalirati Llama 3 na Windows 11 PC .

Kako instalirati Llama 3 na Windows 11 PC

Instaliranje Llame 3 na računalo sa sustavom Windows 11 putem Pythona zahtijeva tehničke vještine i znanje. Međutim, neke alternativne metode omogućuju vam lokalnu implementaciju Llame 3 na vašem računalu sa sustavom Windows 11. Pokazat ću vam ove metode.

Da biste instalirali Llama 3 na svoje računalo sa sustavom Windows 11, morate izvršiti neke naredbe u naredbenom retku. Međutim, to će vam omogućiti samo korištenje njegove verzije naredbenog retka. Morate poduzeti daljnje korake ako želite koristiti njegovo web sučelje. Pokazat ću vam obje ove metode.

isključeno je lokalno bežično sučelje

Implementirajte Llama 3 na PC sa sustavom Windows 11 putem CMD-a

Da biste implementirali Llamu 3 na svoje Windows 11 računalo, morate instalirati Ollamu na svoje Windows računalo. Koraci za isto su sljedeći:

- Posjetiti Ollamina službena web stranica .

- Kliknite na preuzimanje gumb, a zatim odaberite Windows .

- Sada kliknite na Preuzmite za Windows gumb za spremanje exe datoteke na vaše računalo.

- Pokrenite exe datoteku da instalirate Ollamu na svoj stroj.

Nakon što se Ollama instalira na vaš uređaj, ponovno pokrenite računalo. Trebao bi raditi u pozadini. Možete ga vidjeti u traci sustava. Sada kliknite na opciju Modeli na web stranici Ollama. Vidjet ćete njegove različite modele.

Llama 3.1 je dostupan u sljedeća tri parametra:

- 8B

- 70B

- 405B

Posljednji je najveći parametar i očito se ne može pokrenuti na nižem računalu. Llama 3.2 ima sljedeća dva parametra:

- 1B

- 3B

Kliknite verziju Llame koju želite instalirati na svoje računalo. Na primjer, ako želite instalirati Llama 3.2, kliknite na Llama 3.2. Na padajućem izborniku možete odabrati parametar koji želite instalirati. Nakon toga kopirajte naredbu pored nje i zalijepite je u naredbeni redak.

Radi vaše udobnosti, napisao sam obje naredbe za model Llama 3.2. Za instalaciju modela Llama 3.2 3B pokrenite sljedeću naredbu:

ollama run llama3.2:3b

Za instalaciju modela Llama 3.2 1B koristite sljedeću naredbu:

ollama run llama3.2:1b

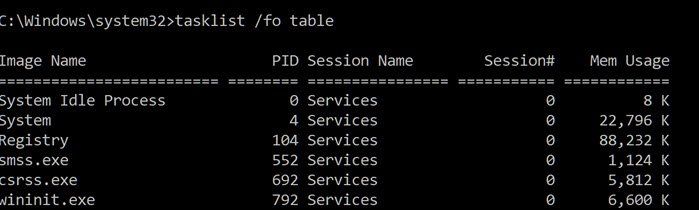

Otvorite naredbeni redak, upišite bilo koju od gore navedenih naredbi (na temelju vaših zahtjeva) i pritisnite Uđi . Za preuzimanje potrebnih datoteka potrebno je neko vrijeme. Vrijeme preuzimanja također će ovisiti o brzini vaše internetske veze. Nakon završetka, vidjet ćete uspjeh poruku u naredbenom retku.

Sada upišite svoju poruku za korištenje modela Llama 3.2. Ako želite instalirati model Llama 3.1, koristite naredbe dostupne na web stranici Ollama.

kako napraviti sigurnosnu kopiju skype povijesti razgovora

Sljedeći put kada pokrenete naredbeni redak, upotrijebite istu naredbu za pokretanje Llame 3.1 ili 3.2 na računalu.

Instalacija Llame 3 putem CMD-a ima jedan nedostatak. Ne sprema vašu povijest razgovora. Međutim, ako ga implementirate na lokalnom hostu, vaša povijest razgovora bit će spremljena i dobit ćete bolje korisničko sučelje. Sljedeća metoda pokazuje kako to učiniti.

Implementirajte Llama 3 Web UI na Windows 11

Korištenje Llame 3 na web pregledniku pruža bolje korisničko sučelje i također sprema povijest razgovora u usporedbi s korištenjem u CMD prozoru. Pokazat ću vam kako implementirati Llamu 3 na vašem web pregledniku.

Za korištenje Llame 3 u vašem web pregledniku, Llama 3 preko Ollame i Dockera trebaju biti instalirani na vašem sustavu. Ako još niste instalirali Llamu 3, instalirajte je pomoću Ollame (kako je gore objašnjeno). Sada preuzmite i instalirajte Docker sa svog službena web stranica .

Nakon instaliranja Dockera, pokrenite ga i prijavite se za stvaranje računa. Docker neće raditi dok se ne prijavite. Nakon prijave, prijavite se na svoj račun u aplikaciji Docker. Minimizirajte Docker na System Tray. Aplikacije Docker i Ollama trebale bi raditi u pozadini. U suprotnom, ne možete koristiti Llama 3 u svom web pregledniku.

Sada otvorite naredbeni redak, kopirajte sljedeću naredbu i zalijepite je u naredbeni redak:

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

Gornjoj naredbi trebat će neko vrijeme za preuzimanje potrebnih resursa. Stoga, imajte malo strpljenja. Nakon završetka naredbe, otvorite Docker i odaberite Kontejneri odjeljak s lijeve strane. Vidjet ćete da se spremnik automatski stvara s portom 3000:8080.

super prefetch windows 7

Kliknite na port 3000:8080. Ovo će otvoriti novu karticu u vašem zadanom web pregledniku. Sada se prijavite i prijavite za korištenje Llame 3 u svom web pregledniku. Ako vidite adresnu traku, vidjet ćete lokalni host: 3000 tamo, što znači da se Llama 3 nalazi lokalno na vašem računalu. Možete ga koristiti bez internetske veze.

S padajućeg izbornika odaberite svoj model Llama chata. Ako želite dodati još modela chata Llame 3, morate ga instalirati putem Ollame koristeći potrebne naredbe. Nakon toga, model će automatski biti dostupan u vašem web pregledniku.

Sva vaša povijest razgovora bit će spremljena i dostupna s lijeve strane. Kada želite izaći, odjavite se svoju sesiju u svom web pregledniku. Nakon toga otvorite aplikaciju Docker i kliknite na Stop gumb za zaustavljanje Dockera. Sada možete zatvoriti Docker.

Kada sljedeći put poželite koristiti Llamu 3 u svom web pregledniku, pokrenite Ollamu i Docker, pričekajte nekoliko minuta, a zatim kliknite port u Docker spremniku da biste otvorili poslužitelj lokalnog hosta u svom web pregledniku. Sada se prijavite na svoj račun i počnite koristiti Llama 3.

Nadam se da će ovo pomoći.

Može li Llama 3 raditi na Windowsima?

Ovisno o hardverskoj konfiguraciji vašeg računala, možete pokrenuti Llamu 3 na svom sustavu. Njegov model 1B je najlakši. Možete ga instalirati i pokrenuti na vašem sustavu putem naredbenog retka.

Koliko RAM-a trebam za Llama 3?

Najlakši model Llame 3 je Llama 3.2 1B. Vaš sustav bi trebao imati 16 GB RAM-a za pokretanje modela Llama 3.2 1B. Uz to, vaš sustav također treba imati GPU za teške uvjete rada. Viši modeli Llame 3 zahtijevaju više resursa sustava.

Pročitaj sljedeće : Kako koristiti Leonardo Phoenix AI .